En tiempo real

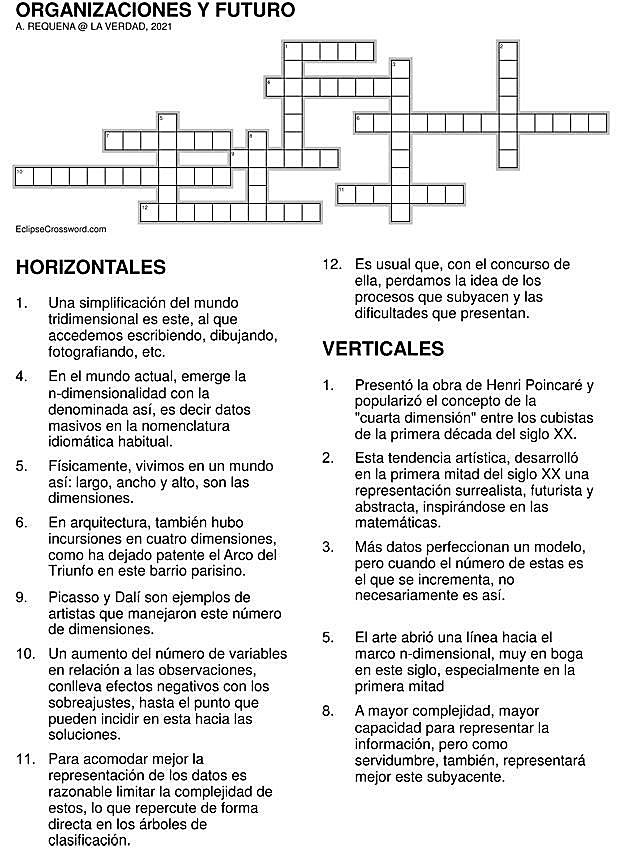

Es usual que, con el concurso de la tecnología, perdamos la idea de los procesos que subyacen y las dificultades que presentan. Físicamente, vivimos en ... un mundo tridimensional: largo, ancho y alto, son las dimensiones. Una simplificación es el plano, al que accedemos escribiendo, dibujando, fotografiando, para incorporar la imaginación de la tercera coordenada que falta. Superado el trauma que supuso la concepción de que la dimensión no tenía por qué detenerse en la tercera, y que la cuarta es una más, hemos intentado, por todos los medios posibles, visualizarla. El cubismo desarrolló en la primera mitad del siglo XX una representación surrealista, futurista y abstracta, inspirándose en las matemáticas que incorporaban mayor número de dimensiones y avanzaron un mundo radical en su trabajo. Picasso y Dalí son ejemplos de artistas que manejaron las cuatro dimensiones e hicieron proyecciones sobre espacios de dos dimensiones. En arquitectura, también hubo incursiones en cuatro dimensiones, como ha dejado patente el Arco del Triunfo en el parisino barrio de la Defense. El matemático Princet presentó la obra de Henri Poincaré y popularizó el concepto de la «cuarta dimensión» entre los cubistas de la primera década del siglo XX y desencadenó la aplicación. El arte abrió una línea hacia el marco n-dimensional, muy en boga en el siglo XX, especialmente en la primera mitad, pero hoy parece estancado en sus concreciones.

Abierta la espita de la n-dimensionalidad, conceptualmente se asume su presencia y efectividad. En el mundo actual, emerge la n-dimensionalidad con la denominada Big Data, es decir Datos masivos en la nomenclatura idiomática habitual. El escenario lo constituyen el volumen, la heterogeneidad y la velocidad de generación de datos. Cuando el mundo informático era más moderado, se pensaba, que cuantos más datos se dispusiera, mejor. No necesariamente es así, dado que, si bien más datos perfeccionan un modelo, cuando el número de variables es el que se incrementa, no necesariamente es así. Se hace necesario lograr un equilibrio entre complejidad y capacidad de generalización. A mayor complejidad, mayor capacidad para representar la información, pero como servidumbre, también, representará mejor el ruido subyacente. Como resultado final es que las predicciones no tendrán la calidad requerida. Es común este problema en el tratamiento de los datos meteorológicos, por ejemplo. Para acomodar mejor la representación de los datos es razonable limitar la complejidad de los modelos, lo que repercute de forma directa en los árboles de clasificación.

Así pues, un aumento del número de variables en relación a las observaciones, conlleva efectos negativos con los sobreajustes, hasta el punto que pueden incidir en la convergencia hacia las soluciones. Se suele operar en dos frentes: en la selección de las variables y en la extracción de nuevas variables que se generan mediante transformaciones de las originales. Al margen de las variadas técnicas para llevar a cabo el tratamiento de datos, lo relevante es que se requiere imaginación para adaptar procedimientos que surgieron en otros entornos y emplearlos en el Big Data, por analogía, como tantas veces ha ocurrido en el ámbito científico. La denominada regularización, identificando nuevas variables que emergen de las originales, como acontece en la regresión multivariable, identificando dependencia de unas variables con otras o la identificación de clusters de variables, son auténticos retos científicos y técnicos que inciden de forma significativa en la dimensionalidad y, como consecuencia, en el Big Data.

Podríamos pensar que este es un problema del ámbito académico, pero nada más lejos de la realidad. Insensiblemente, cada vez estamos más inmersos en el mundo de Big Data y ello significa que hablamos de gran cantidad de información de carácter sensible. Por tanto, es imprescindible contar con mecanismos que aseguren su confidencialidad e integridad, mediante sistemas de control de acceso y cifrado. Más importante es el tratamiento de esos datos, desproporcionadamente numerosos, imposibles de tratar con herramientas usuales como las bases de datos y las técnicas convencionales. El procesado de la información, hoy económica y eficiente gracias a la tecnología disponible, permite que una empresa conozca no solo sus propios procesos, sino los gestos y patrones de comportamiento de los clientes, para poder ofrecer sugerencias a medida, intentando fidelizarlos. Esto hace que la variedad de la información, el acceso y las decisiones que tomamos a partir de su análisis y tratamiento de los datos hace que la analítica en tiempo real configure el futuro de las organizaciones. No es ninguna broma. De ahí su importancia.

Respuestas

¿Tienes una suscripción? Inicia sesión