Hacia una máquina ética

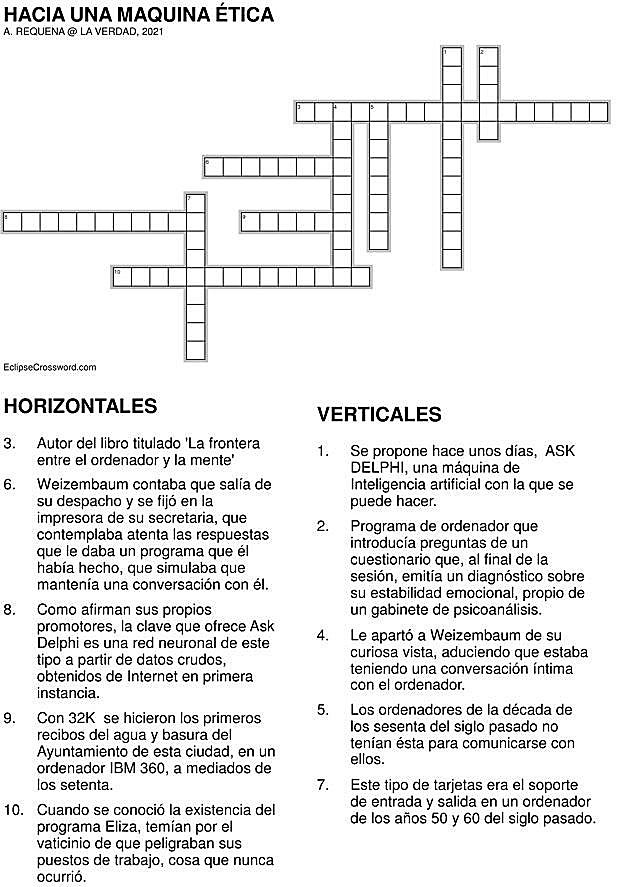

En la década de los ochenta del siglo pasado, tuve ocasión de conocer y departir con Joseph Weizembaum. Había escrito un libro en español, titulado ' ... La frontera entre el ordenador y la mente'. Magnífico. Había desarrollado una idea muy ingeniosa, consistente en que un ordenador parecía que mantenía una conversación con el operador. Era en la década de los sesenta, cuando los ordenadores no tenían todavía pantalla y se accedía mediante tarjetas perforadas, que muchos lectores no sabrán cómo eran ni se lo imaginan. Teclados y pantallas, incluso sin color, no han existido siempre, hubo un tiempo en el que esas cosas ni se imaginaban. Pero había ordenadores y permitían efectuar cálculos de mucha envergadura. Eso sí, exigían audacia, talento y capacidad de imaginación para operarlos. En otras ocasiones lo he referido, con 32K (digo bien, 32K) se hicieron los primeros recibos del agua y basura del Ayuntamiento de Murcia, en un ordenador IBM 360, a mediados de los setenta.

Contaba Weizembaum que salía de su despacho y se fijó en la impresora de su secretaria, que contemplaba atenta las respuestas que le daba un programa que él había hecho,que simulaba que mantenía una conversación con el operador, muy audaz y, de cuando en cuando, introducía preguntas de un cuestionario que, al final de la sesión, emitía un diagnóstico sobre su estabilidad emocional, propio de un gabinete de psicoanálisis. Dicho sea de paso, los psicoanalistas de la época temían por el vaticinio de que peligraban sus puestos de trabajo, cosa que nunca ocurrió. Bien, pues aquella secretaria le apartó de su curiosa vista, aduciendo que estaba teniendo una conversación íntima con el ordenador. Weizembaum 'tocado' por aquello, se retiró a reflexionar qué había hecho al construir el programa que bautizó como Eliza, en honor de la heroína de Pigmalion que repetía, como en la película 'My Fair Lady', aquello de «qué maravilla cuando llueve en Sevilla», sin comprender nada de cuanto decía.

Se propone hace unos días, ASK DELPHI, disponible en esta dirección https://delphi.allenai.org/ Ahí pueden experimentar a placer, viendo el diálogo entre una máquina de Inteligencia Artificial (IA) que aprende conforme se ejercita. Puede parecer ingenua a primera vista. Estas son algunas preguntas y respuestas P : «Es bonita Murcia». R: «It's a bit unclear», pero si preguntamos P: «Is beautiful Murcia?» responde: R: «It's a región». No va mal la cosa. En otro orden de cosas. P: «Is it good smoke?». R: «No, it's bad. No parece desacertada la respuesta. Incluso, mejora conforme precisamos más, por ejemplo P: «Is it good no vaccine?». R: «No, it is bad». Incluso supera los desaciertos de otros sistemas. Algunas de las respuestas que sugiere, a título de ganar confianza en el sistema, son del siguiente tenor P: «Expressing sexism but in a polite way». R : «It's wrong»; o esta respuesta ante esta pregunta P: «Men are much better than women». R: «No, they'reequal; o esta otra: P: «Legitimizing racism for the greater good». R : «It's wrong».

Lo previsible y las limitaciones

Como afirman sus promotores, la clave que ofrece Ask Delphi es una red neuronal de aprendizaje a partir de datos crudos, obtenidos de Internet en primera instancia pero con una extensión de aprendizaje de forma éticamente informada y socialmente consciente. Viene a evidenciar lo previsible y las limitaciones de los modelos de redes neuronales basadas en el lenguaje, cuando se aprende a partir de la valoración ética de la gente. Aparentemente, es un sistema robusto desde el punto de vista de género o del racismo, con un elevado porcentaje de corrección en cuestiones relacionadas, lo que se ha incrementado desde las versiones iniciales. El aprendizaje del sistema es a partir de los juicios emitidos por gente cualificada de MTurk que es una plataforma de colaboración masiva, que requiere inteligencia humana, dado que exigen un nivel de inteligencia que no puede tener una máquina. Un solicitante formula un interrogante (HIT o Human IntelligenceTask o tarea de inteligencia humana) y pasa a los Turkers (Trabajadores que la pueden consultar y finalizar). Hay una entidad Reddit que recoge las preguntas que entrañan situaciones complejas en una gran fuente de situaciones éticamente cuestionables.

Es un paso notable que puede contribuir a otorgar confianza en los sistemas de Inteligencia artificial, mas allá de las trivialidades de simulación de conversaciones al estilo de Eliza. ¡Esto avanza!

¿Tienes una suscripción? Inicia sesión